背景

下午从某个搞笑视频里听到火影忍者里面的OP,突然很想重温一下其中的一部分剧情,想起几年前最后一次更新的本地库里的集数并不全,有些集数还因为数据来源混乱的原因分辨率特别差。索性想办法这次更新一个完整集合,结合我最近知道的一个爬数据利器。

非(shi)常(zai)感(bao)谢(qian)优酷为我们提供的数据支撑,目前我看到的是所有数据全部无限制可播,所以我应该不用考虑VIP权限和cookie的问题了。下载方法优先想到的是you-get,虽然下载过程中发现有些问题,不过还是想办法绕了过去。其中最大的问题就是--playlist / -l没有生效,貌似是输入url类型不对,不过我始终找不到优酷关于这个播放列表的页面逻辑,貌似并不存在想youtube那样的playlist的单独页面,它只有单集的播放页面,播放列表是嵌套在所有单集页面的右侧的,you-get目前的实现可能还没有覆盖到那一部分数据解析,所以始终提示我找不到下一集。

不想在这个时候去给他们修bug,只能想办法手动找到所有单集的页面地址,然后一一传给you-get去处理了。找了前几集的页面url看了一下规则,也是有规则可寻的,但是优酷在集数之外又有一层分组的逻辑,比如第1-30是第一部分,第31-60是第二部分,依次类推…每个部分的单集url又不一样,这就开始无聊了….我尝试直接在shell里用for生成批量的url然后下载,有两个问题,每个集数部分的URL会不一样,我需要重新不断更换格式化字符串,其次是页面中目前的url中夹杂着特殊符号包括!和 ~,这些符号好像会在shell里面直接被展开,加双引号都没起作用。直接放弃了。

Web Scraper

祭出大杀器Web Scraper,之前看了官方的几个引导视频,但是目前还是不会用太高级的功能,就直接从最基础的操作入口。 爬虫的开源项目已经满天飞了,各式各样的姿势都有,但是一旦中断维护的项目几乎就算是废掉了,因为网站改版了或者服务升级了。 起初好像是我发现A站上有各种搞笑视频拼接起来的合集,把各种小视频片段拼接起来,然后选择性加一些文案到视频里面,热度都还挺高,所以我想了一下自己实践的可行性。 但是慢慢开始写的时候很多想法又变了,比如: 核心的操作其实还是下载和上传的自动化,加上任务的自动化管理,所以就放弃了从Twitter上爬视频。虽然我很久之前就写过爬Twitter的各种媒体资源,但是不想一开始就把重心放在视频片段管理和合并的逻辑上。 最后转向从youtube上爬取,因为相比之下不需要管理片段和合并的操作了。 但是这么做还是会有一些侵权风险。 上传视频到A站的自动化应该是我给自己挖的最大的坑了吧,因为我用了Selenium,但是没有一次性考虑好运行环境的问题。 起初并没有想那么多,打算写完了部署在Google Cloud (GCP) 或者Raspberry Pi 3B+或者家里的mac-mini上的,考虑用Selenium还是没什么大问题的。优先选择GCP的原因是从youtube上下载速度必然非常快,但是上传到A站服务器一定会慢,但是应该还能接受。 用Selenium的时候最开始我用的是Chrome/chrome-driver,平时不觉得,但是在gcp上跑的第二天后就提醒我该系统升级了,内存已经超载了,GCP应该是有一个tolerance time,前面几天运行没有问题,但是很快就炸了。由于某些不可描述的原因,我还在薅GCP那300刀的羊毛,创建的实例只有0.6G的最低内存配置,升级系统会加速消费速度,猜测还会影响其他已经在运行的其他服务的带宽,所以最终迁移到了Raspberry Pi上。 家里的RPi最近一次用是用来部署一个Kodi结合Plex的家庭影音平台,后来因为搬家的原因所以基本闲置了。我忘了几年前买它时候的配置,那还是一个armv7l的32bit架构。Chrome又坑了我一次,不知道具体从什么时候开始,Google放弃了支持32bit的Chrome for linux。这下完犊子了,我在Debian 9上各种尝试找到最后一个支持32bit的chrome和chromedriver安装包,尝试dpkg离线安装但是死活不成功,好像是依赖库的版本和其他软件不兼容的问题。 实在没办法了,Selenium还是支持不少其他webdriver的,优先考虑的自然是Firefox,庆幸的是FF还是一直32bit的(给Mozilla点个赞!),安装过程很顺利。但是运行过程中又碰到了一个奇怪的问题,辗转几次定位到了是virtual display的问题。奇怪的是在GCP上使用Chrome并没有问题,不知道是GCP还是Chrome做了额外的处理。 UPDATE

有时候会在晚上睡觉之前开始在mac mini上下几个大文件或者跑 于是问题来了,我要么找到结束当前正在一直运行的这个命令再重新编辑(追加 在这之前我是知道 以Create new sitemap -> Input a start-url -> Add new selector -> Input a name ->

Video crawler project

ffmpeg合并视频,选择性加一些文案。

Unix Process State

问题

brew update,等命令跑到一半发现不想再继续等下去了,因为等待的时间比预期的远远要长。我又不想因为一句命令让机器一整晚上都运行着,还是想着应该让这个命令结束之后再立刻休眠(pmset sleepnow)。&& pmset sleepnow)达到效果,要么想办法找到那个进程执行完毕的那个时间点。其实对于brew update这类命令的话,结束执行再跑一点儿关系都没有,主要还是针对curl和封装了curl的任务,毕竟杀掉了重新来过一般只能重新开始。思路

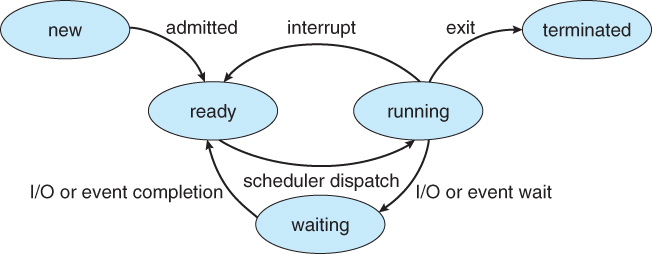

jobs, fg和bg这几个常用命令的:一个在运行的程序,如果我发送Ctrl+Z的组合时间给它,就相当于挂起(suspend)了这个进程,这个时候开始它只能等待恢复(或者直接被杀掉)。jobs能直接查看到当前shell的进程列表中所有的任务列表,通过fg可以把最顶端挂起的任务恢复并分发到前台运行模式,相当于把目标任务提到了当前shell的正在执行的命令模式,相当于接替上一个状态继续执行。bg的作用基本一致,区别在于目标任务被分到了后台运行模式,当前shell仍然处于带输入模式接受下一个命令的执行。如果不考虑stdout或者目标任务的stdout被重定向到了其他文件,bg会表现得目标任务不存在一样,直到执行完毕会从后台运行模式下输出一个进程执行完毕的提示。sleep举例: